Salah satu grup idola ternama Jakarta, pada 4 Januari kemarin mengeluarkan pernyataan resmi terkait penyalahgunaan teknologi akal imitasi (AI) setelah foto beberapa personel telah diedit oleh akun yang tidak bertanggung jawab menggunakan fitur Grok yang disediakan oleh Elon Musk, pemilik media sosial X.

Fitur edit gambar ini sendiri dimunculkan oleh X pada akhir tahun 2025, dimana pengguna media sosial tersebut dapat me-mention Grok untuk mengedit gambar apapun yang diunggah di X dengan prompt tertentu. Hal ini memicu kontroversi besar, yang mulanya dipicu dari para seniman gambar dan ilustrator. Fitur ini akhirnya merambah untuk meng-prompt foto-foto orang lain tanpa persetujuan pemilik foto, baik dalam konteks biasa hingga yang mengarah pada tindakan asusila.

Penulis terpikirkan menulis topik ini setelah membaca artikel dari Kompas yang berjudul “Mengapa Orang Khawatir dengan AI?” Rasanya artikel ini masih relevan dan mungkin ke depannya akan sama. Pembahasan ini sempat disinggung sedikit pada artikel Pulang Teater yang membahas fenomena sexual harrasment di ranah fandom grup idola Jakarta.

Ini adalah artikel pertama untuk rubrik “Diskusi Digital” yang akan berfokus tentang bagaimana penulis memandang fenomena teknologi yang ramai saat ini. Tulisan ini akan membagikan perspektif penulis yang mungkin tidak terjangkau dalam pembahasan profesional penulis sebagai Software Tester di Medium.

Fenomena Akal Imitasi di Dunia

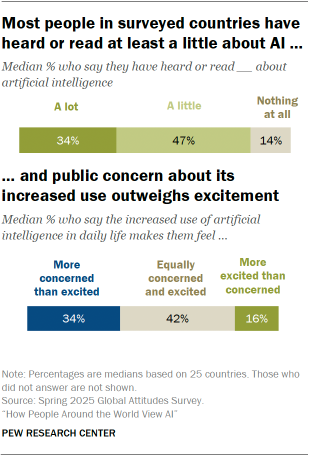

Pew Research pada Oktober 2025 merilis survei yang diambil dari 25 negara terkait kemunculan kecerdasan buatan atau akal imitasi. Hasilnya, tergambar pandangan para responden antara harapan dan kekhawatiran. Kecenderungannya lebih condong pada kekhawatiran.

Sekitar 34 persen responden mengaku khawatir dengan kemunculan AI. Hanya sekitar 16 persen yang mengaku lebih antusias. Sementara itu, 42 persen berada di tengah, yakni antara antusias dan khawatir.

Pada survei tersebut, responden dari negara-negara maju, memiliki tingkat kekhawatiran hingga 45 persen ke atas. Hal ini menunjukkan kemunculan AI menjadi kekhawatiran masyarakat dari latar belakang kelas negara yang berbeda.

Di Indonesia, misalnya, hanya 18 persen responden yang menilai di negaranya orang sudah mendengar dan membaca soal AI. Sebaliknya, 43 persen responden menilai orang Indonesia belum sama sekali terpapar dengan AI.

Kesimpulan sementaranya, keterpaparan yang tinggi terhadap AI pun membawa tingkat kecemasan yang lebih tinggi. Dalam konteks di tanah air, tingkat kekhawatiran orang terhadap AI dibandingkan antusiasme berada di angka 32 persen. Angka ini termasuk dalam kategori menengah.

Perspektif dari Pekerja Bidang Teknologi Informasi

Sebagai seorang profesional di bidang Software Quality Assurance (QA), tugas harian penulis adalah mencari bug, menguji batas kemampuan sistem, dan memastikan bahwa sebuah produk teknologi aman serta layak digunakan. Dalam dunia QA, kami mengenal istilah edge cases—skenario ekstrem di mana sebuah sistem bisa gagal atau berperilaku di luar kendali.

AI telah menjadi asisten yang luar biasa dalam pekerjaan kami. Ia mampu mempercepat pembuatan skrip pengujian otomatis, menganalisis log data yang masif dalam hitungan detik, hingga membantu memprediksi potensi bug sebelum terjadi.

Di sisi lain, dengan pekerjaan yang selalu melihat perspektif alat teknologi dari kacamata end-user atau pengguna akhir seperti masyarakat umumnya, ada pandangan bahwa kedekatan struktur teknis dan interaksi lebih sering dengan AI justru kita harus semakin waspada.

Penulis melihat bagaimana AI hanya bisa dirancang untuk bekerja berdasarkan pola, bukan moral. Jika sebuah sistem tidak dibatasi oleh protokol keamanan yang ketat (dan sayangnya, banyak pengembang yang mengabaikan ini demi kecepatan rilis), maka AI hanyalah sebuah mesin yang siap mengeksekusi apa pun, termasuk perintah yang destruktif.

AI atau kecerdasan buatan pada dasarnya bekerja dengan cara “belajar dari data”. Sama seperti manusia belajar dari pengalaman, AI belajar dari informasi yang diberikan kepadanya. Misalnya, jika kita memberi ribuan foto kucing dan anjing, AI akan berlatih membedakan keduanya berdasarkan pola—seperti bentuk telinga, warna bulu, atau ukuran tubuh—hingga akhirnya bisa menebak dengan cukup tepat apakah sebuah foto berisi kucing atau anjing.

Proses ini dimulai dengan mengumpulkan data, lalu AI dilatih menggunakan data tersebut agar bisa mengenali pola. Setelah itu, AI bisa digunakan untuk menghadapi situasi baru. Contohnya, setelah dilatih dengan foto-foto hewan, AI dapat langsung menebak jenis hewan dari foto yang belum pernah dilihat sebelumnya. Semakin banyak data dan latihan yang diberikan, biasanya hasil AI akan semakin baik dan akurat.

Beberapa AI modern bekerja lebih canggih lagi dengan menggunakan “jaringan saraf tiruan” yang terinspirasi dari cara kerja otak manusia. Dengan cara ini, AI bisa melakukan hal-hal kompleks, seperti mengenali suara, memahami bahasa, atau bahkan membuat gambar dan tulisan. Sederhananya, AI adalah sebuah sistem pintar yang bisa belajar, mengenali pola, dan membantu manusia menyelesaikan banyak tugas lebih cepat dan efisien.

Manipulasi AI Menjadi Boomerang

Salah satu penyalahgunaan yang paling menghancurkan saat ini adalah penggunaan AI dalam ranah manipulasi gambar. Apa yang awalnya diciptakan untuk membantu fotografer memperbaiki pencahayaan atau menghapus objek pengganggu, kini telah bergeser menjadi senjata pemusnah karakter.

Masih ingat soal bagaimana seorang mahasiswa perguruan tinggi di Bandung ditangkap polisi hanya karena mengedit foto dua tokoh pemimpin di tanah air sedang berciuman menggunakan AI. Kasus ini hanyalah satu dari sekian banyak risiko yang terjadi akibat penyalahgunaan AI, tanpa harus dalam konteks politik semata.

Deepfake adalah gambar, video, atau audio yang telah diedit atau dibuat menggunakan alat berbasis AI. Kecerdasan buatan bergantung pada masukan manusia, dan fitur pembelajaran mesinnya memungkinkannya beradaptasi berdasarkan data yang kita berikan

Kita melihat maraknya penggunaan fitur image-to-image atau generative fill untuk memanipulasi foto seseorang menjadi konten pornografi (deepfake pornography). Beberapa waktu lalu sempat ramai sebuah kejadian dimana ada sebuah aplikasi AI yang dapat meng-generate seolah-olah seseorang berfoto figur publik, bahkan dengan pose tertentu seperti memeluk dan mencium. Hal ini jelas melanggar privasi dari figur publik tersebut. Ini adalah pelanggaran privasi yang sangat berat karena:

- Tanpa Konsen (Consent): Foto santai seseorang dari media sosial bisa diambil dan diubah menjadi konten asusila tanpa izin pemiliknya.

- Aksesibilitas yang Berbahaya: Dulu, memanipulasi foto membutuhkan keahlian Photoshop tingkat tinggi. Sekarang, siapa pun yang memiliki akses internet dan sedikit “akal imitasi” bisa melakukannya dalam hitungan menit.

- Dampak Psikologis Permanen: Bagi korban, jejak digital ini sulit dihapus dan menimbulkan trauma mendalam, sementara pelaku merasa aman di balik anonimitas layar.

Masalah yang lebih besar mungkin bukan terletak pada mereka yang berniat jahat atau masalah degradasi moral semata, melainkan pada jutaan orang yang menggunakan AI tanpa pengetahuan yang memadai. Sebagai QA, saya tahu bahwa setiap input yang kita berikan ke sebuah program akan tersimpan di database. Dalam ranah AI, sering kali data input tersebut menjadi data latihan bagi model tersebut.

Banyak pengguna tidak sadar bahwa dengan mengunggah foto pribadi atau dokumen rahasia perusahaan ke dalam alat AI “gratisan”, mereka secara sukarela menyerahkan privasi mereka. Berdalih ingin membangun memori yang tak sempat diabadikan atau memperbaiki sesuatu yang berharga bagi mereka untuk dapat dikembalikan secara utuh.

Inilah yang dikhawatirkan, merasa canggih karena dapat mengelaborasi penggunaan teknologi terbaru namun tidak paham risiko keamanan data dan etika penggunaannya.

Menghadapi Masa Depan dengan Waspada

Tentu kita tidak bisa bergerak sendiri sebagai user. Harus ada intervensi dari pemangku kepentingan di berbagai negara di dunia serta kerja sama optimal dengan platform AI dan media sosial yang menggunakannya.

Meskipun rasanya cukup pesimis dengan pernyataan tersebut, kita bisa melakukan minimalisasi risiko. Kita tidak bisa memutar jarum jam kembali. Namun, sebagai orang yang berkecimpung dalam kualitas dan keamanan perangkat lunak, penulis ingin menegaskan bahwa AI harus memiliki rem, bukan hanya pedal gas.

“Kami Juga Khawatir” adalah seruan agar kita tidak hanya menjadi penonton yang terpukau. Kita butuh regulasi yang tegas terhadap platform AI yang membiarkan konten asusila dihasilkan, dan kita butuh edukasi publik agar masyarakat paham bahwa di balik kemudahan AI, ada tanggung jawab besar yang harus dipikul.

Sebelum kita menyerahkan lebih banyak aspek kehidupan kita kepada “Akal Imitasi”, pastikan akal sehat dan empati manusia tetap menjadi standar kualitas tertinggi yang kita miliki.